Konfiguracja robots.txt w Drupalu

Odpowiednia konfiguracja pliku robots.txt jest kluczowa w optymalizacji SEO każdej witryny internetowej. W przypadku stron na Drupalu, moduł RobotsTxt jest dobrym narzędziem do kontrolowania tego pliku. Z artykułu dowiesz się więcej o samym module oraz pliku robots.txt. Zapoznasz się również z tworzeniem i konfiguracją pliku robots.txt w Drupalu.

Czym jest moduł RobotsTxt?

Czym jest moduł RobotsTxt?

Moduł RobotsTxt to przydatne narzędzie w Drupalu, który istotnie poprawia optymalizację pod względem SEO. Pozwala szybko i prosto zarządzać plikiem robots.txt. Jest w zasadzie standardem wykorzystywanym przez strony internetowe do komunikacji z robotami wyszukiwarki, za pomocą definiowania instrukcji dla konkretnych User agent.

Robots.txt to nic innego jak klasyczny plik tekstowy. Ma natomiast w swoim zapisie wytyczne przygotowane dla robotów crawlujących. Jego głównym celem jest nadzór nad interakcją wyszukiwarek i innych botów ze stroną. Chociaż może naprawdę skutecznie kierować dobrze robotami indeksującymi, nie powinien być traktowany jako jedyne zabezpieczenie. Niektóre złośliwe boty mogą ignorować reguły zapisane w pliku. Jeśli masz strony lub treści, których nie chcesz upubliczniać, warto sięgnąć po dodatkowe środki zabezpieczenia, takie jak mechanizmy uwierzytelniania i autoryzacji.

Instalacja modułu

Instalacja modułu

Przy instalacji do wyboru masz dwa sposoby:

- Ręczne pobranie i umieszczanie plików w katalogu modułów.

- Skorzystanie z menedżera pakietów Composer (co jest zalecane).

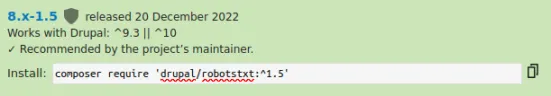

W przypadku opcji z użyciem Composer jedyne co musisz zrobić, to wykonać polecenie pobierające moduł RobotsTxt oraz jego zależności. Wszystkie niezbędne informacje związane z instalacją modułu znajdziesz w dokumentacji.

1. Otwórz wiersz poleceń i wprowadź: composer require 'drupal/robotstxt:^1.5'. Moduł zostanie pobrany w wersji co najmniej 1.5, zgodnej z Drupal 9.3 i nowszymi wersjami.

2. Aktywuj moduł w panelu administracyjnym, przechodząc do zakładki Rozszerzenia (pod adresem /admin/modules).

Alternatywnie skorzystaj z polecenia: drush en robotstxt w wierszu poleceń.

Po zakończeniu krótkiego procesu instalacji, moduł jest gotowy do użycia. Teraz możesz bez przeszkód z niego korzystać.

Jak stworzyć swój plik robots.txt?

Jak stworzyć swój plik robots.txt?

Przed napisaniem własnego pliku robots.txt, zapoznaj się z istotnymi regułami i dodatkowymi informacjami, które mogą okazać się pomocne. Sama struktura pliku nie jest zbyt skomplikowana.

Najważniejsze zasady

Poprawnie zapisane instrukcje w pliku robots.txt są zorganizowane w dwóch częściach. W pierwszej definiujesz, jakich user-agentów dotyczy poniższa instrukcja. Każda wymaga wskazania user-agent, do którego się odnosi. W drugiej części podane są konkretne instrukcje określające, które pliki, katalogi lub strony mają być przeszukiwane, a które nie.

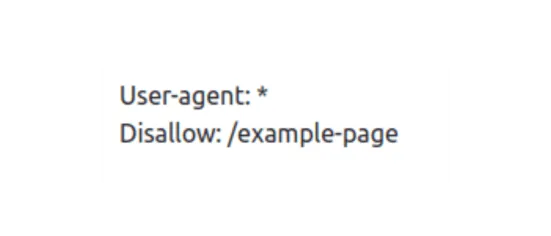

W regułach znaczenie ma wielkość liter! Na przykład użycie:

będzie blokować stronę /example-page , dla wszystkich robotów wyszukiwania, ale strona /Example-Page czy /EXAMPLE-PAGE nie będzie podlegać tej regule. Istnieje możliwość dodawania komentarzy, używając znaku #. Będą one ignorowane podczas przetwarzania.

Używane instrukcje

W pliku korzysta się z określonych terminów:

- user-agent - określa nazwę robota;

- disallow - uniemożliwia przeszukiwanie podanych plików, katalogów lub stron;

- allow - nadpisuje powyższą instrukcję, pozwalającą na skanowanie plików, stron internetowych i katalogów;

- sitemap - wskazuje na lokalizację mapy witryny (* - oznacza dowolną liczbę znaków; termin jest opcjonalny);

- $ - znak informujący o końcu linii.

Znak $ możesz również wykorzystać do zablokowania strony, która ma ustalone rozszerzenie. Instrukcja disallow: /* .doc$” będzie blokować adresy URL, mające rozszerzenie .doc. Analogicznie możesz postępować z innymi pliki, np. używając disallow: /*.jpg$.

Przykłady użycia

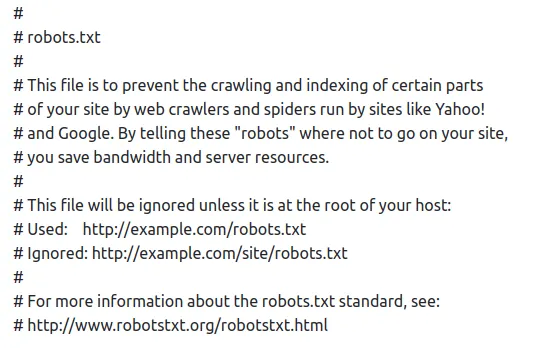

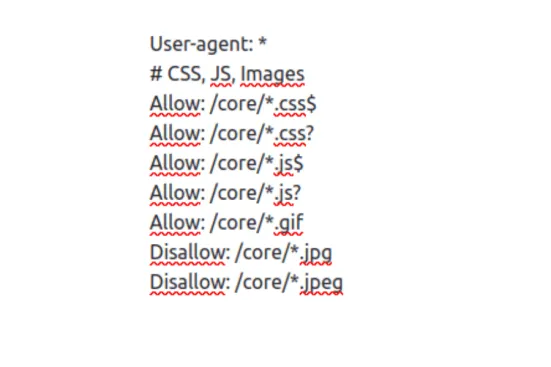

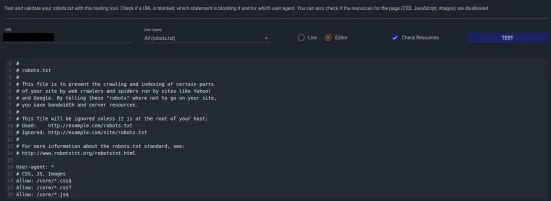

Tak prezentuje się przykładowy plik robots.txt:

Analizując powyższy przykład:

- User-agent: * informuje, że instrukcje zawarte w następnych liniach dotyczą wszystkich robotów indeksujących.

- Allow: /core/*.css$ oznacza, że roboty indeksujące mają pozwolenie na szukanie plików CSS znajdujących się w katalogu "core" witryny. Symbol * daje informację, że plik może mieć dowolną nazwę przed rozszerzeniem ".css", a "$" wskazuje, że nazwa pliku musi kończyć się na ".css".

- Disallow: /core/*.jpeg oznacza, że żaden robot indeksujący nie powinien przeszukiwać plików z rozszerzeniem jpeg znajdującego się w katalogu "core" strony.

Jak poprawnie skonfigurować robots.txt?

Jak poprawnie skonfigurować robots.txt?

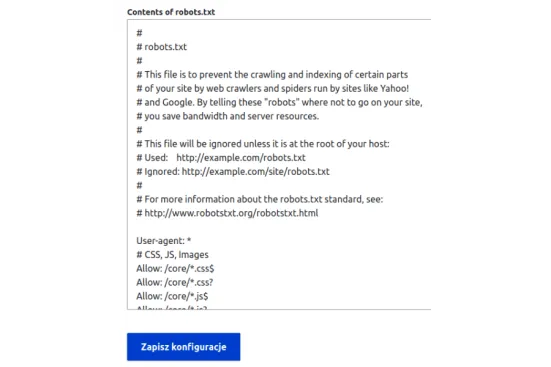

Po zainstalowaniu modułu możesz przejść pod adres: admin/config/search/robotstxt lub kliknąć Configure.

W polu z tytułem Contents of robots.txt wpisz odpowiednie instrukcje dopasowane do potrzeb Twojej witryny.

Po dodaniu wszystkich potrzebnych reguł, kliknij Zapisz konfigurację.

Po zapisaniu pliku, zalecamy go przetestować. Możesz użyć narzędzi do testowania pliku robots.txt dostępnych online, np. technicalseo (SEO TOOLS -> robots.txt Tester).

Pamiętaj, że poprawne skonfigurowanie pliku robots.txt wymaga zaznajomienia się ze specyfiką strony internetowej, zrozumienia jej celów biznesowych oraz potrzeb użytkownika. Nieumiejętne ustawienia mogą spowodować przypadkowe wykluczenia ważnych treści z indeksowania, wpływając niekorzystnie na widoczność witryny w wynikach wyszukiwania.

Pamiętaj więc, że aby moduł RobotsTxt był w pełni sprawny, usuń domyślny plik robots.txt wygenerowany przed Drupala lub zrób jego backup ze zmienioną nazwą. W ten sposób moduł podstawi własny plik robot.txt, a domyślnie wygenerowany podczas procesu tworzenia aplikacji Drupala, zostanie zachowany.

Korzyści z użycia modułu Robots.txt

Korzyści z użycia modułu Robots.txt

Zobacz najważniejsze benefity, płynące z wdrożenia tego rozwiązania na Twoją stronę:

- Wygodne tworzenie i aktualizowanie pliku robots.txt bez konieczności modyfikacji kodu źródłowego.

- Poprawa widoczności w wynikach wyszukiwania.

- Czytelny interfejs użytkownika.

- Pomoc w kontrolowaniu indeksowania obrazów, filmów i innych elementów multimedialnych, niemających wpływu na pozycję Twojej witryny w wynikach wyszukiwania.

- Nadzorowanie sposobu przeglądania Twojej witryny przez roboty. Niekorzystanie z tego pliku może prowadzić do nadmiernego zużycia tzw. "budżetu indeksowania", czyli limitu liczby odwiedzin botów internetowych na Twojej stronie w pewnym czasie. Zbyt duża liczba stron zaindeksowanych może zaszkodzić Twojemu SEO, bo może okazać się, że ważniejsze strony zostaną odsunięte na dalszy plan lub pominięte przez wyszukiwarkę.

- Ograniczenia dostępu do pewnych zawartości lub stron, które niekoniecznie powinny być widoczne dla każdego.

Ograniczenia pliku robots.txt

Ograniczenia pliku robots.txt

Niestety, prawopodobnie jak każde narzędzie, robots.txt nie jest doskonałe i ma swoje ograniczenia.

- Brak standaryzacji - plik oparty jest na zasadach ustalonych przez protokół Robots Exclusion Standard, który nie jest ustandaryzowany pomiędzy różnymi robotami indeksującymi. Mimo że znane roboty zazwyczaj respektują reguły użyte w pliku robots.txt, to jednak każdy z nich może interpretować je nieco inaczej. Dlatego tak ważne jest korzystanie z odpowiedniej składni, by dzięki temu zniwelować możliwość wystąpienia sytuacji, w której pewne polecenia będą nierozpoznane przez roboty;

- ograniczone możliwości blokowania - nie zawsze plik robots.txt zapewni całkowite wyłączenie dostępu do danych zasobów. Pewne boty mimo to wciąż mogą próbować odwiedzić zablokowane strony.

Podsumowanie

Podsumowanie

Moduł RobotsTxt, oferując intuicyjną i szybką konfigurację pliku robots.txt, jest niezwykle przydatnym narzędziem. Wykorzystując możliwości integracji z innymi modułami oraz definiowanie niestandardowych reguł, skutecznie dopasowuje funkcjonowanie pliku robots.txt do potrzeb witryny. Ponadto prosty interfejs i elastyczność w zarządzaniu instrukcjami utwierdzają jedynie w przekonaniu, że moduł jest świetnym rozwiązaniem dla każdego właściciela strony opartej na Drupalu.